背景

最近想提高下沉浸式翻译的翻译质量,原来一直用的 Qwen3 30B A3B 的模型翻译,其实也够用,但是想看看换别的模型有没有什么提升。但是不知道为什么互联网上评测模型翻译的体验内容很少,所以我就自己简单测一下。测试对象是下面这篇 Reddit 帖子,工具使用 沉浸式翻译+自带 Reddit 翻译提示词

然后还有一点是我对速度有要求,所以不接受思考模型,如果测了思考模型我都是把思考关闭了的

省流结果

与现在用的 Qwen3 30B A3B 相比,更大的 Qwen3 系列模型并不会带来更好的翻译效果。从结果上来看,翻译效果好坏似乎与模型体积几乎没有关系。考虑到 GPT 诞生之初本来就是为翻译服务,当时还是一个很小的模型,所以可能对于翻译来说,参数量大小并不是一个决定性因素。

综合来说 Kimi K2 Instruct 0905 效果最好,但是输出比较贵,¥16.00/M,如果 Kimi K2 系列能有一个小模型,那么性价比可能会相当高。

以及这个结果与 https://bench.opensakura.com/ 的测试也比较相近。

详细结果

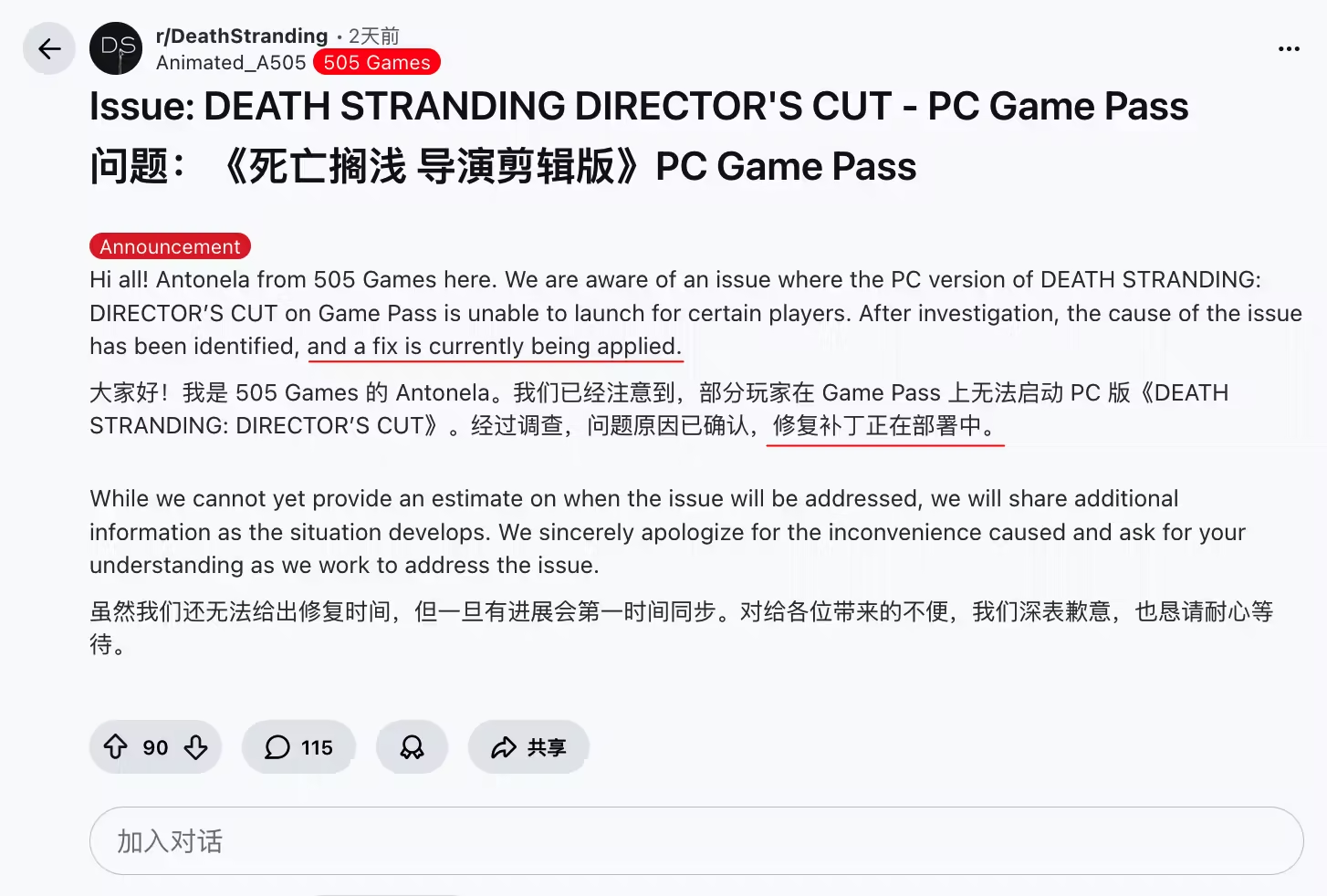

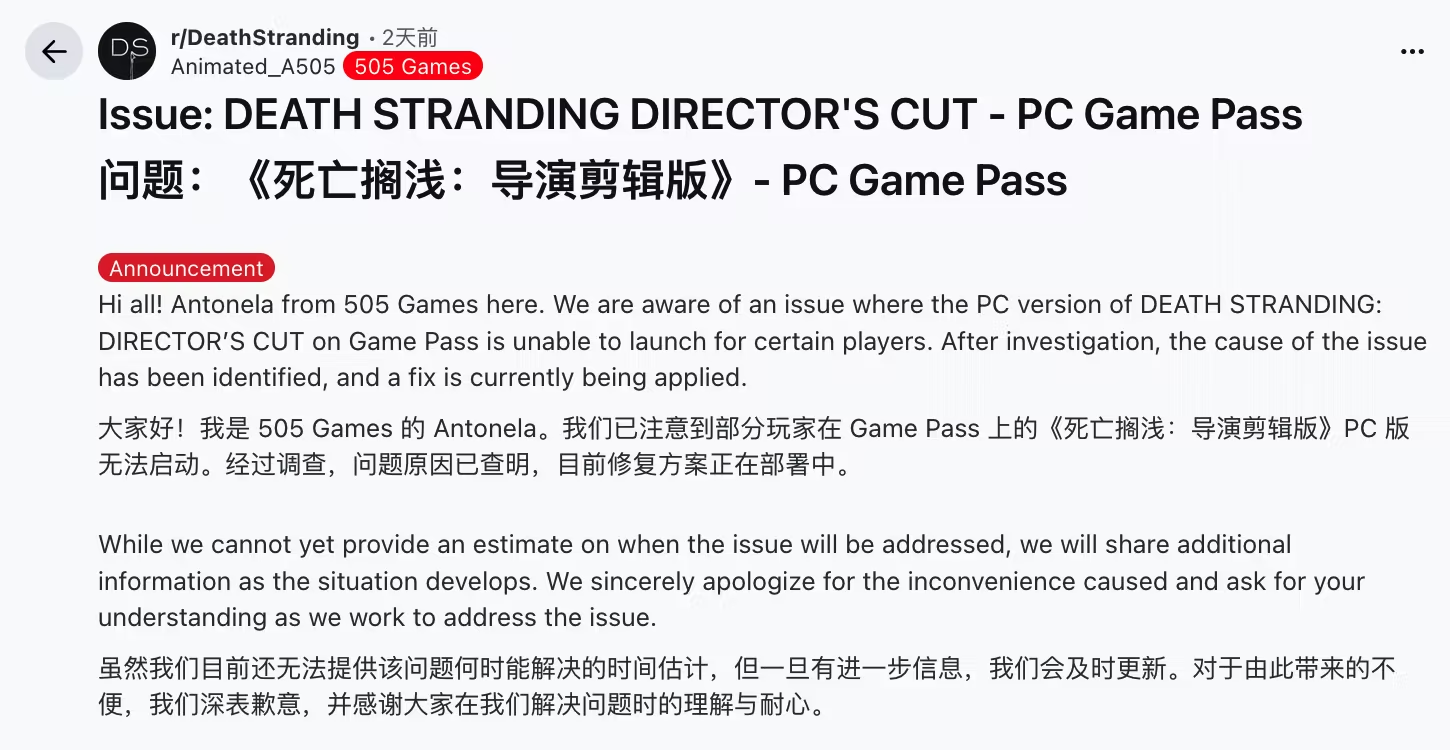

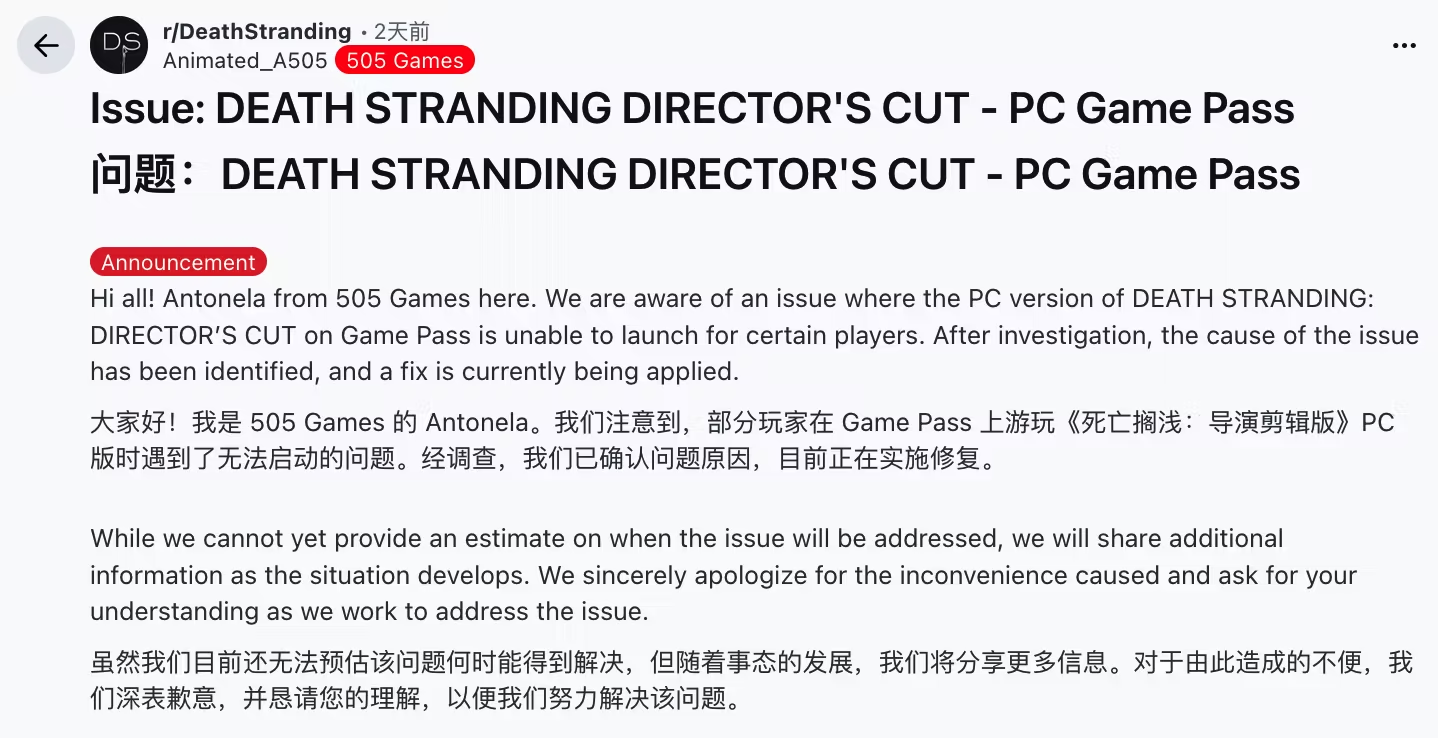

Kimi K2 Instruct 0905

效果最好,而且非常地道。只有划线一处翻译的并不是很好,直接翻译为“正在修复中”会比较合适。

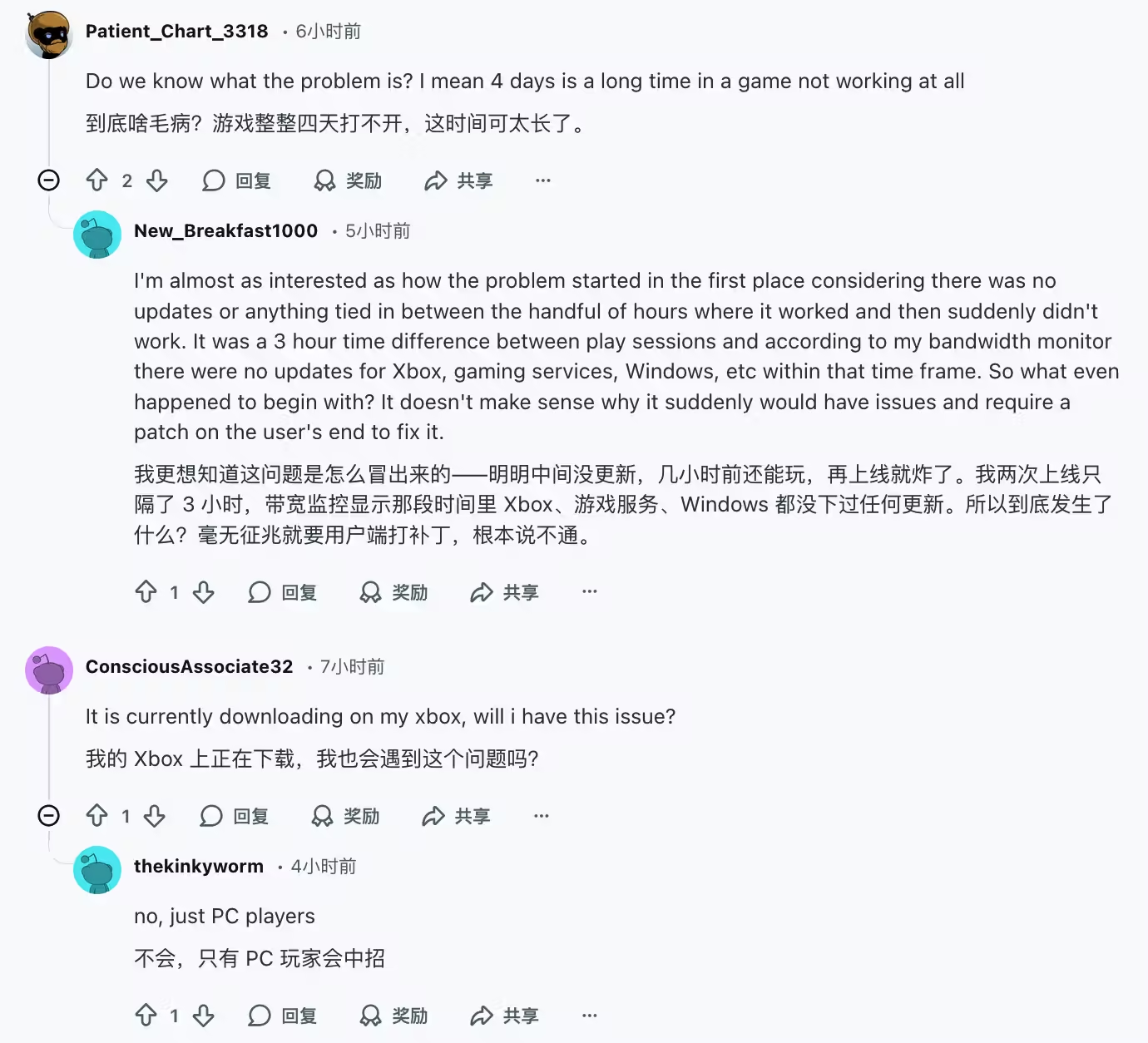

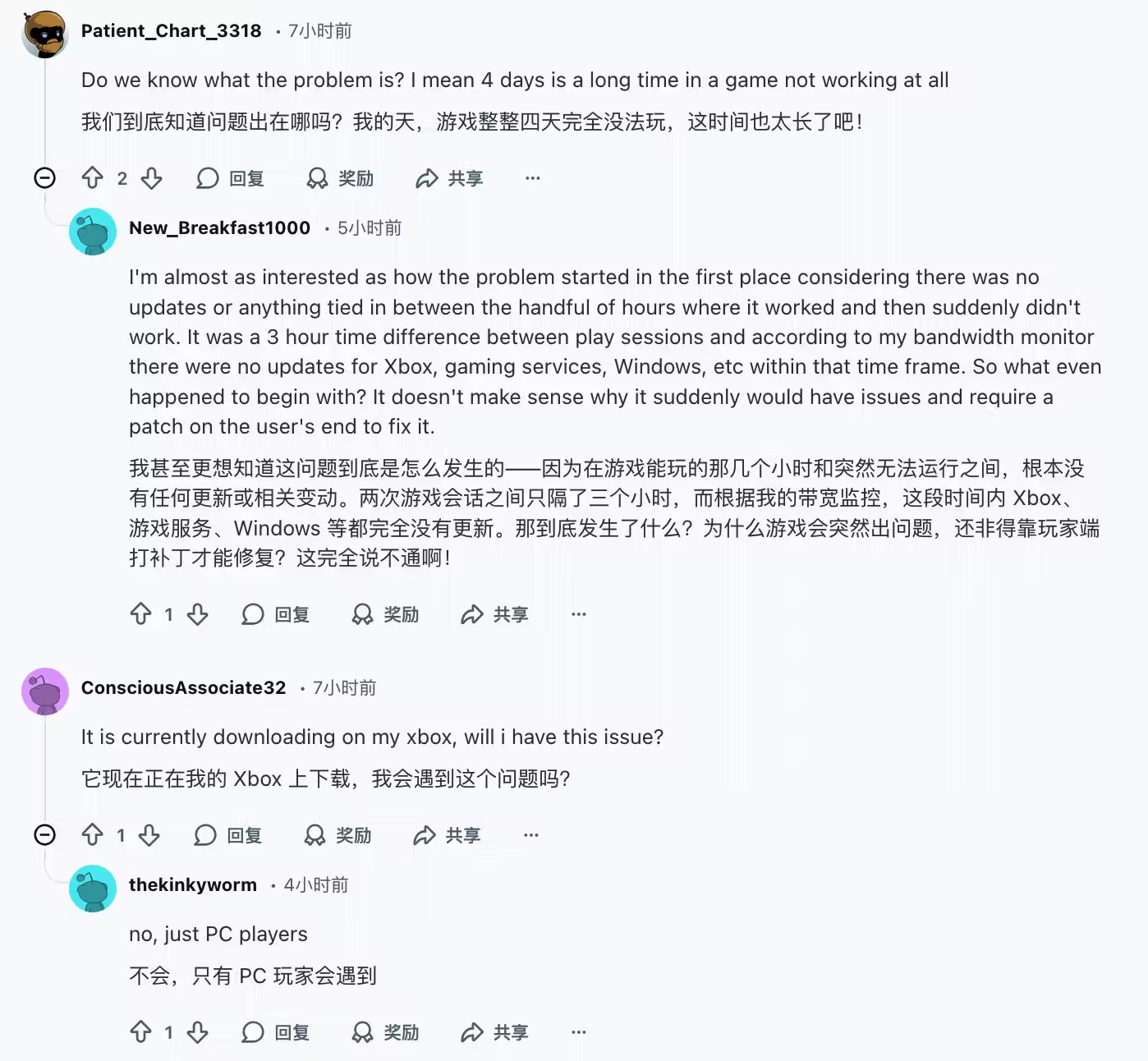

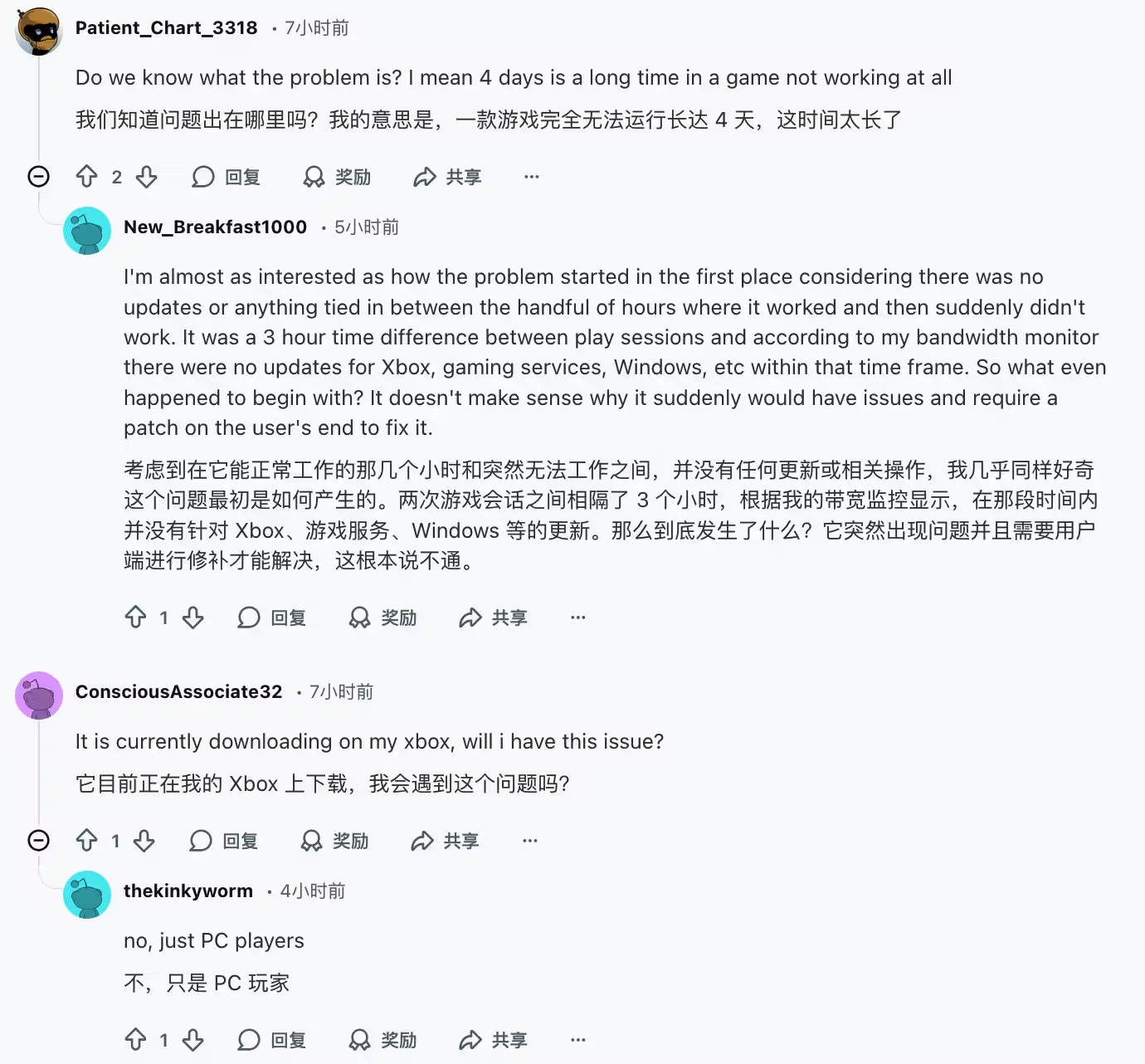

Qwen3 30B A3B Instruct 2507

有一处翻译错误,原文是 a patch on the user’s end,意思是得更新客户端才可以解决问题,并不是用户自己打补丁。这个翻译问题一直贯穿到 Qwen3 Max

Qwen3 Next 80B A3B

Qwen3 Max

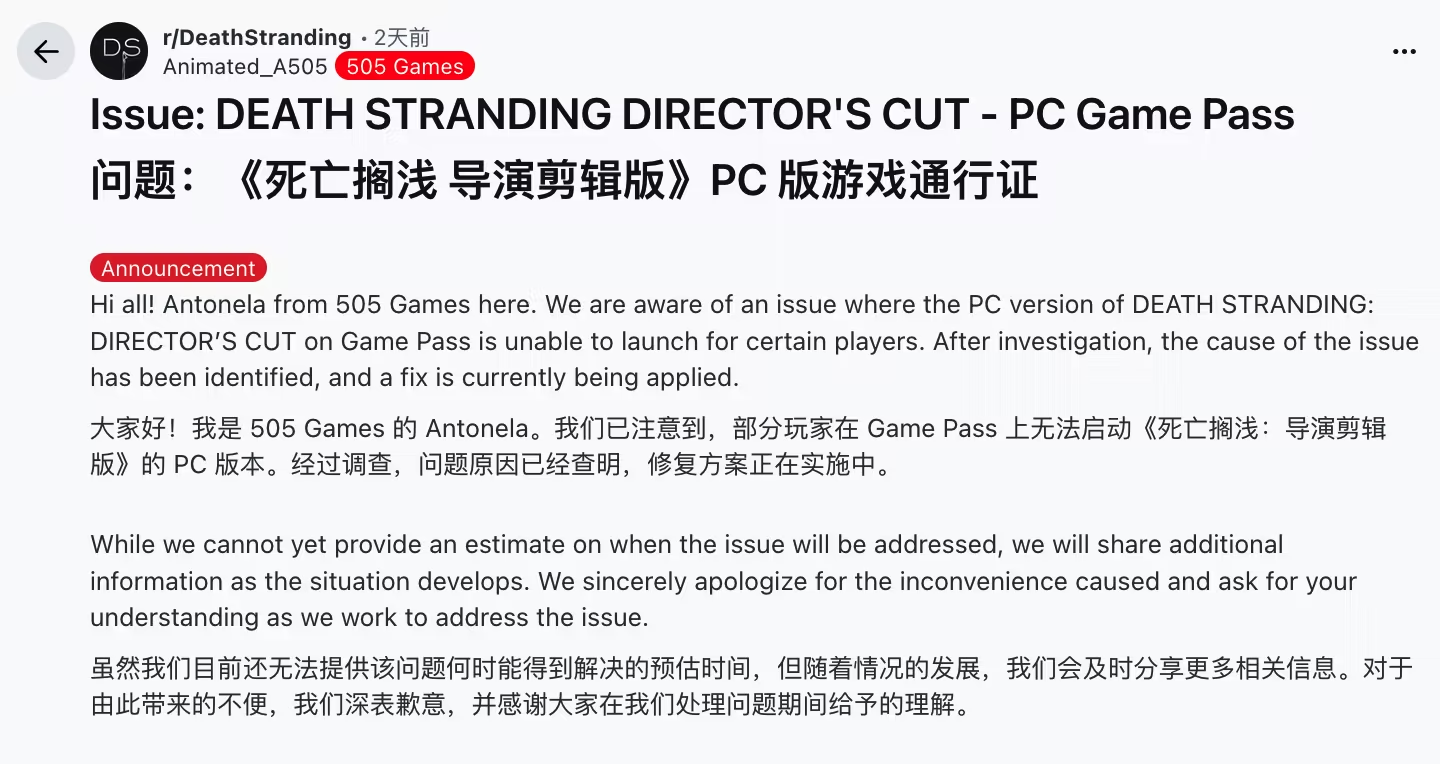

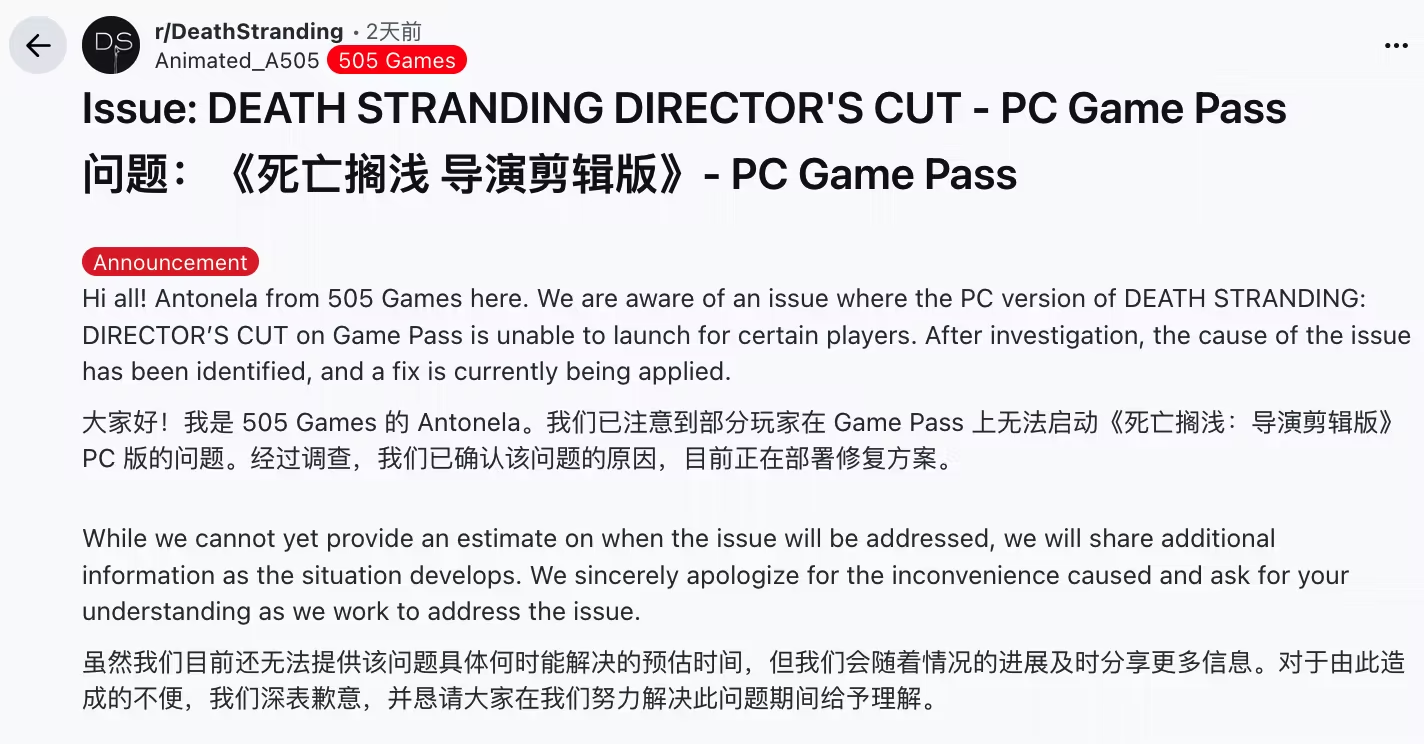

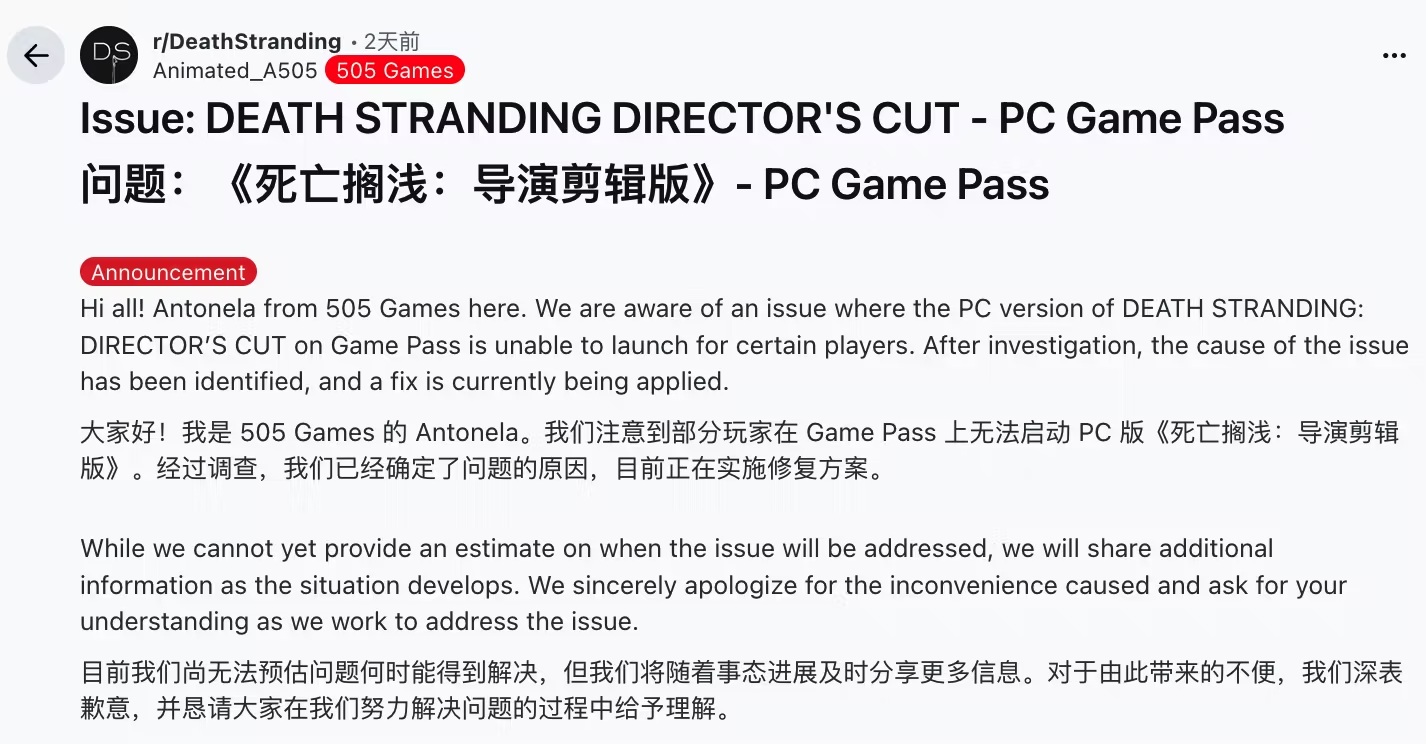

GLM 4.7 Thinking Disabled

效果不好,读起来不通顺切奇怪,看起来 GLM 并不适合拿来翻译

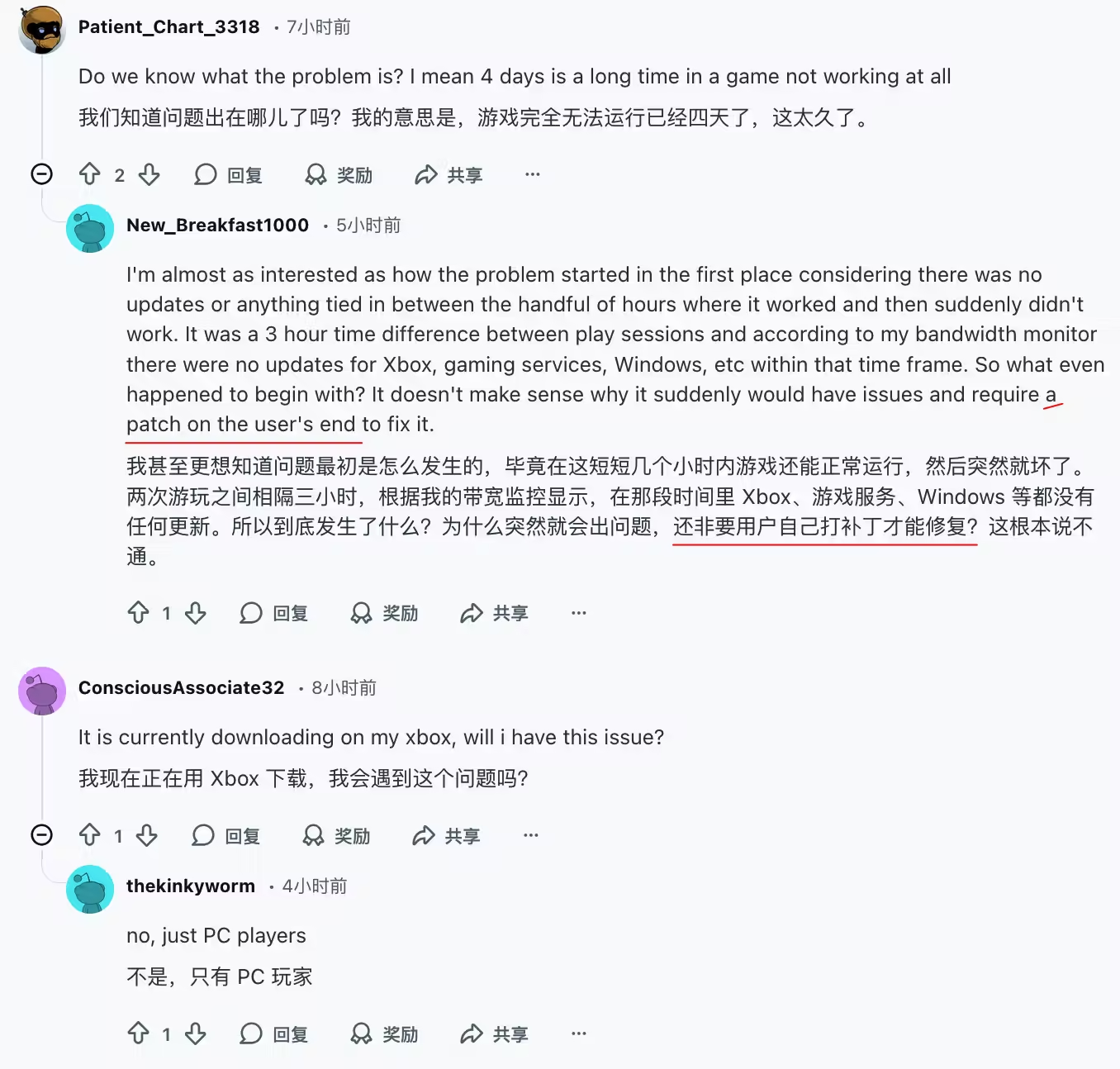

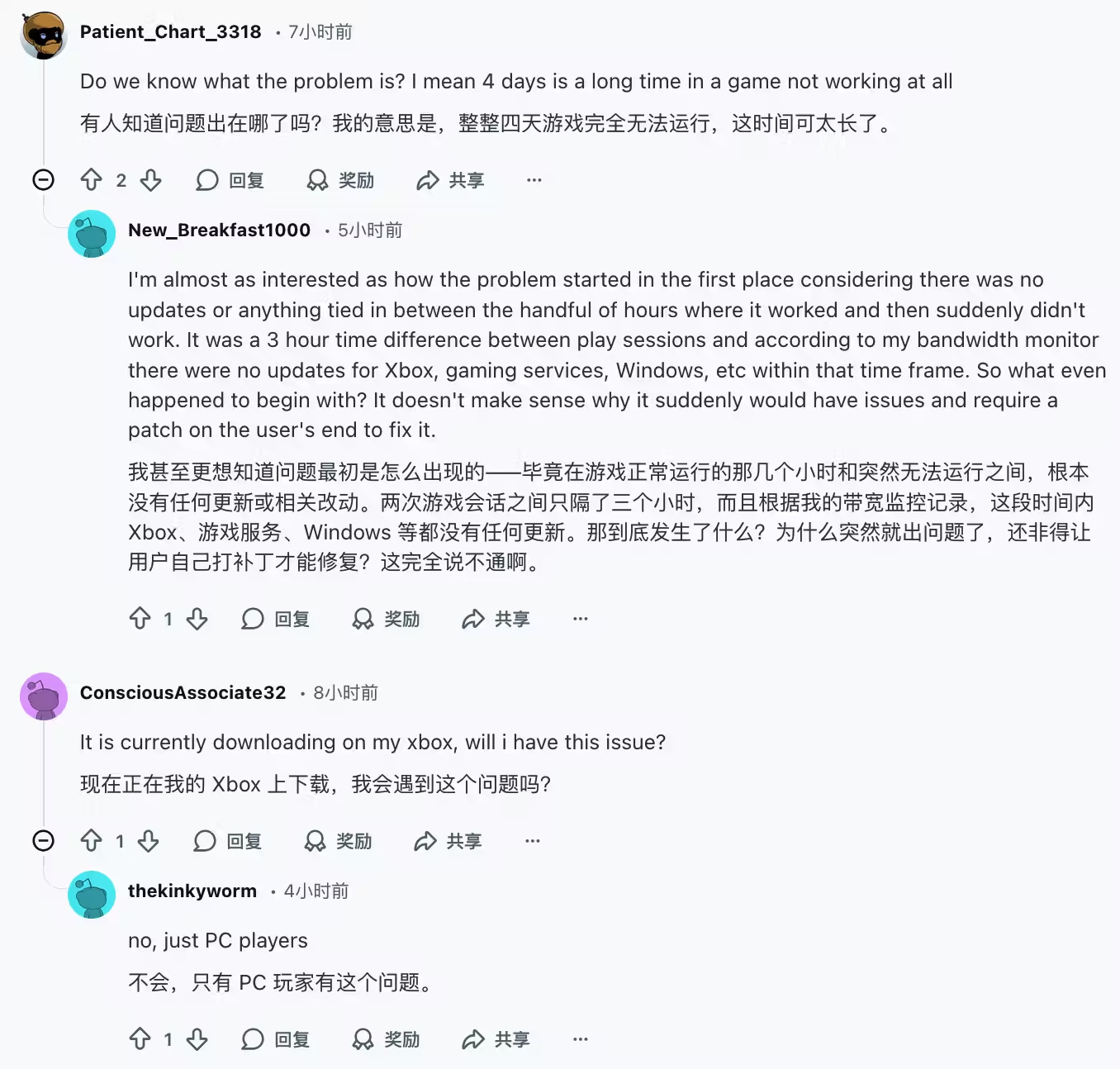

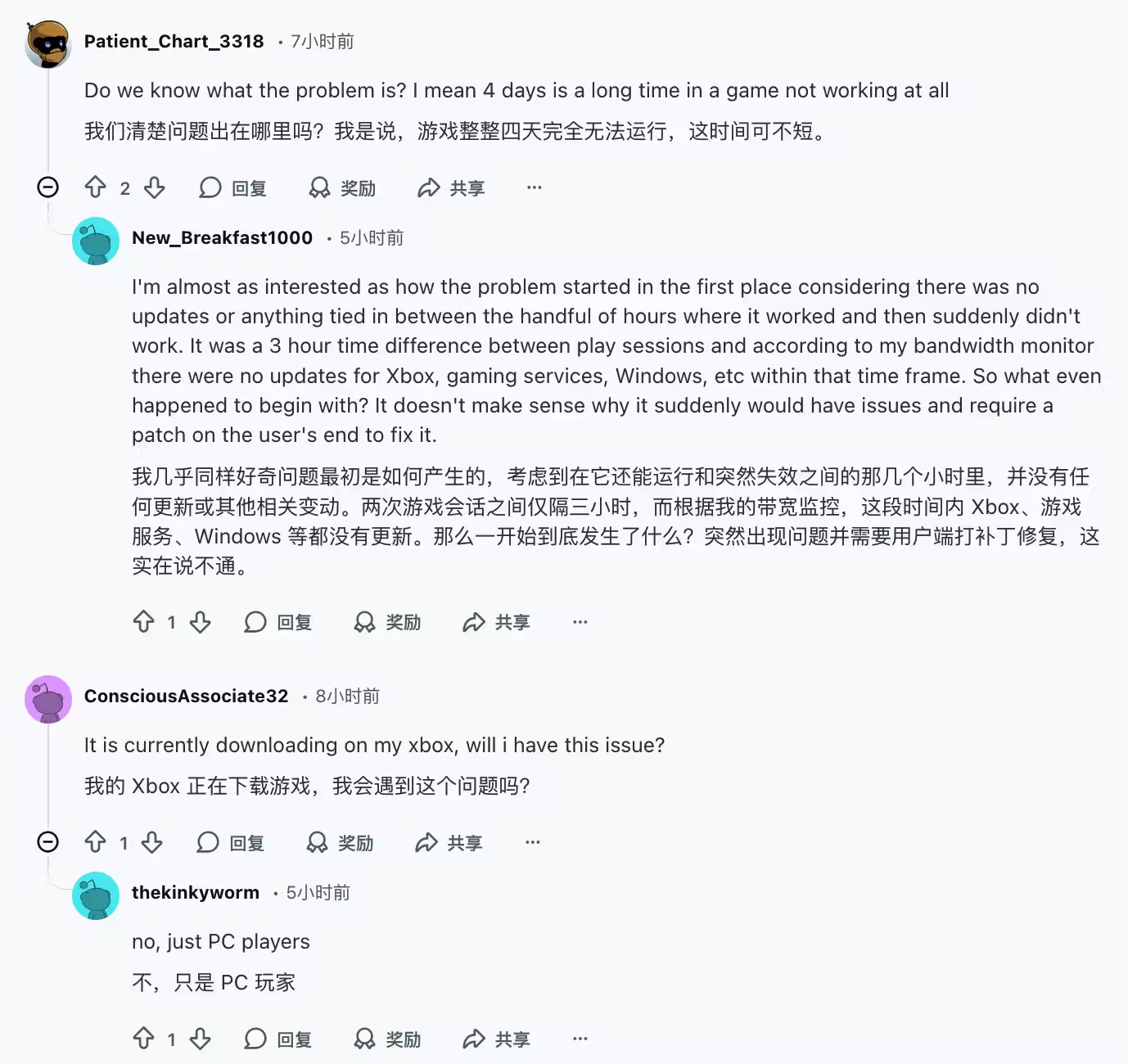

DeepSeek V3.2 Thinking Disabled

跟 GLM 坐一桌

Photo by Mike Hindle on Unsplash